LM Studio工具记录(含CherryStudio RAG知识库测试)

下载安装

LM Studio 官网- Discover, download, and run local LLMs

官网点击下载安装即可,过程中可选择安装路径(这点比Ollama方便点)

配置

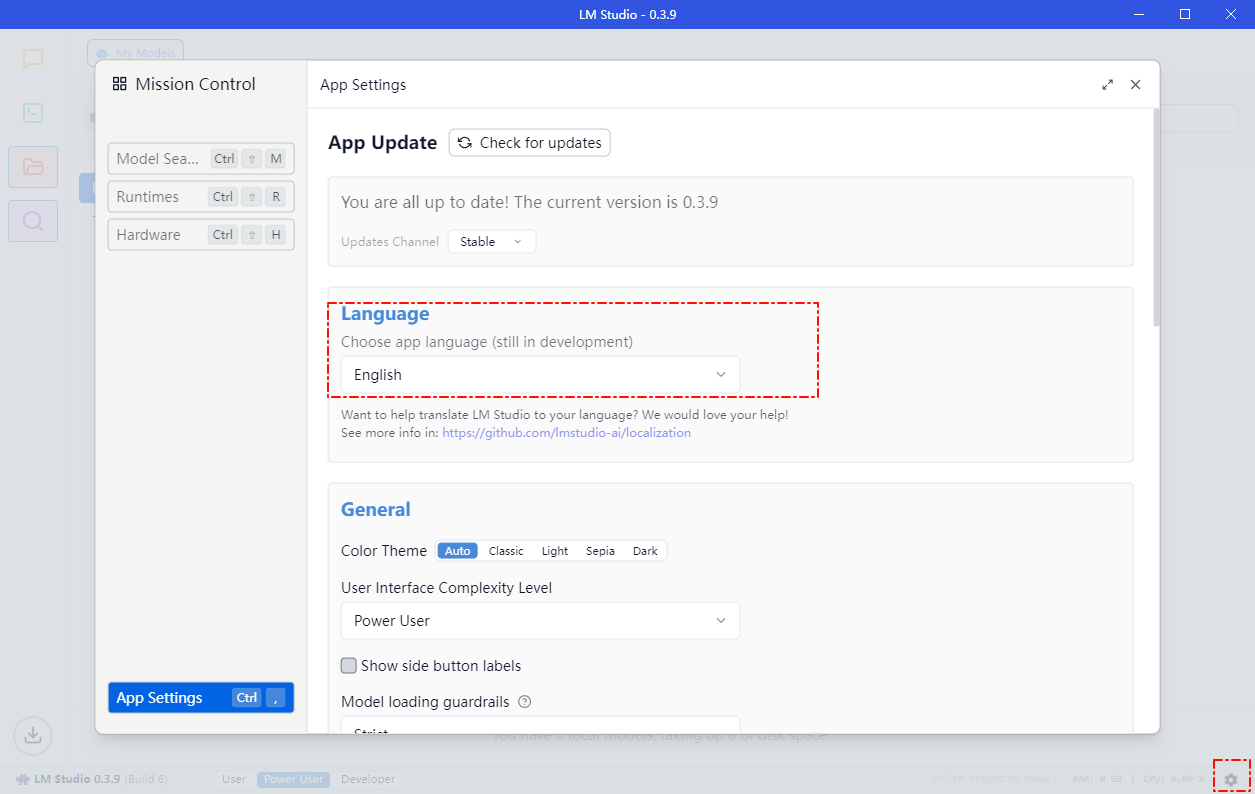

中文设置

右下角齿轮设置处可配置语言为中文

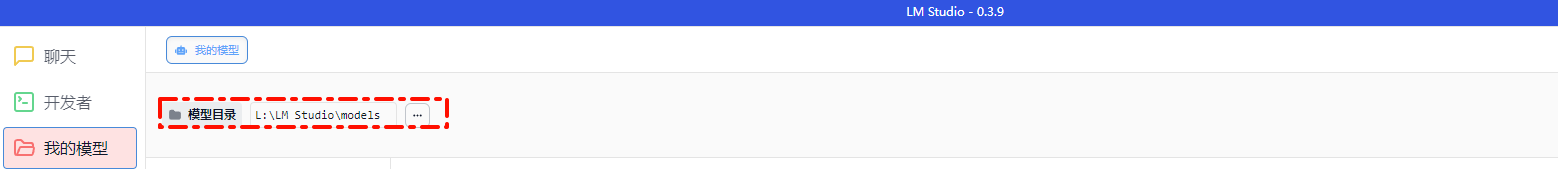

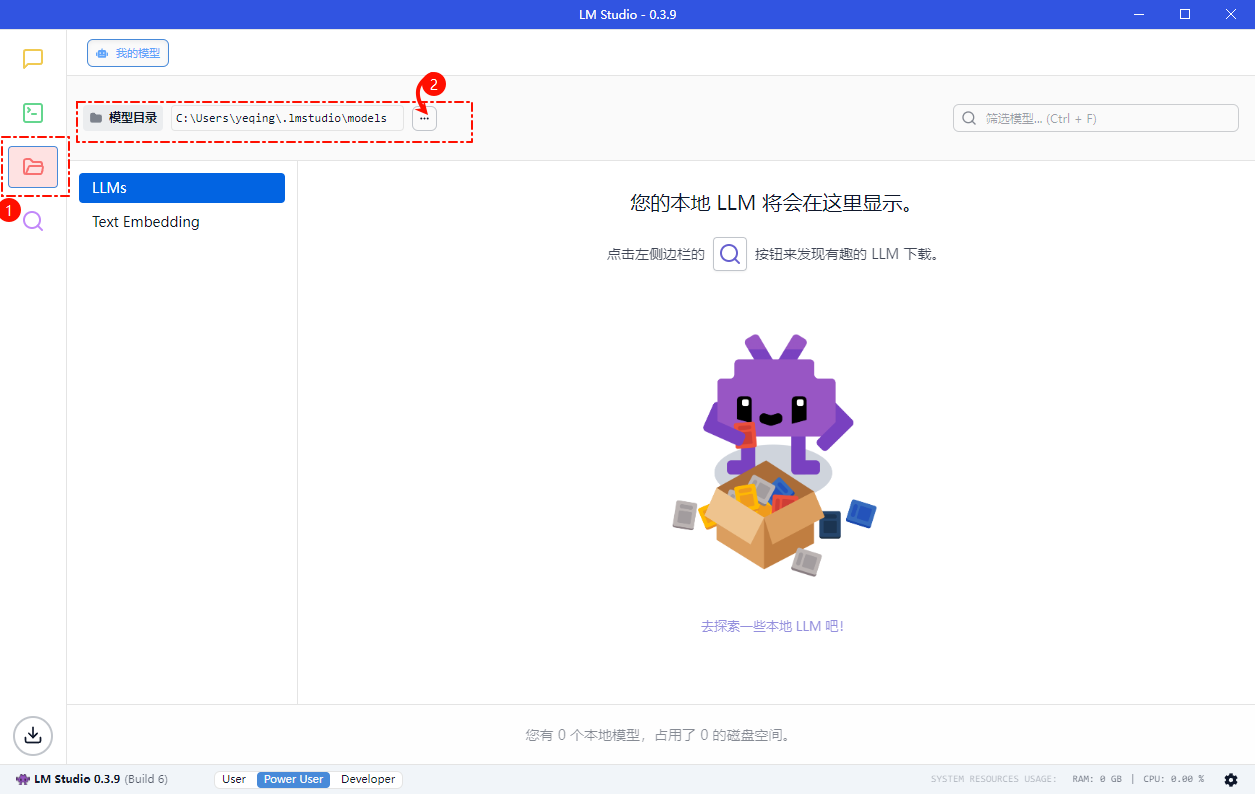

配置模型存放目录

默认是C盘,建议修改配置到其他空间充足的盘符目录

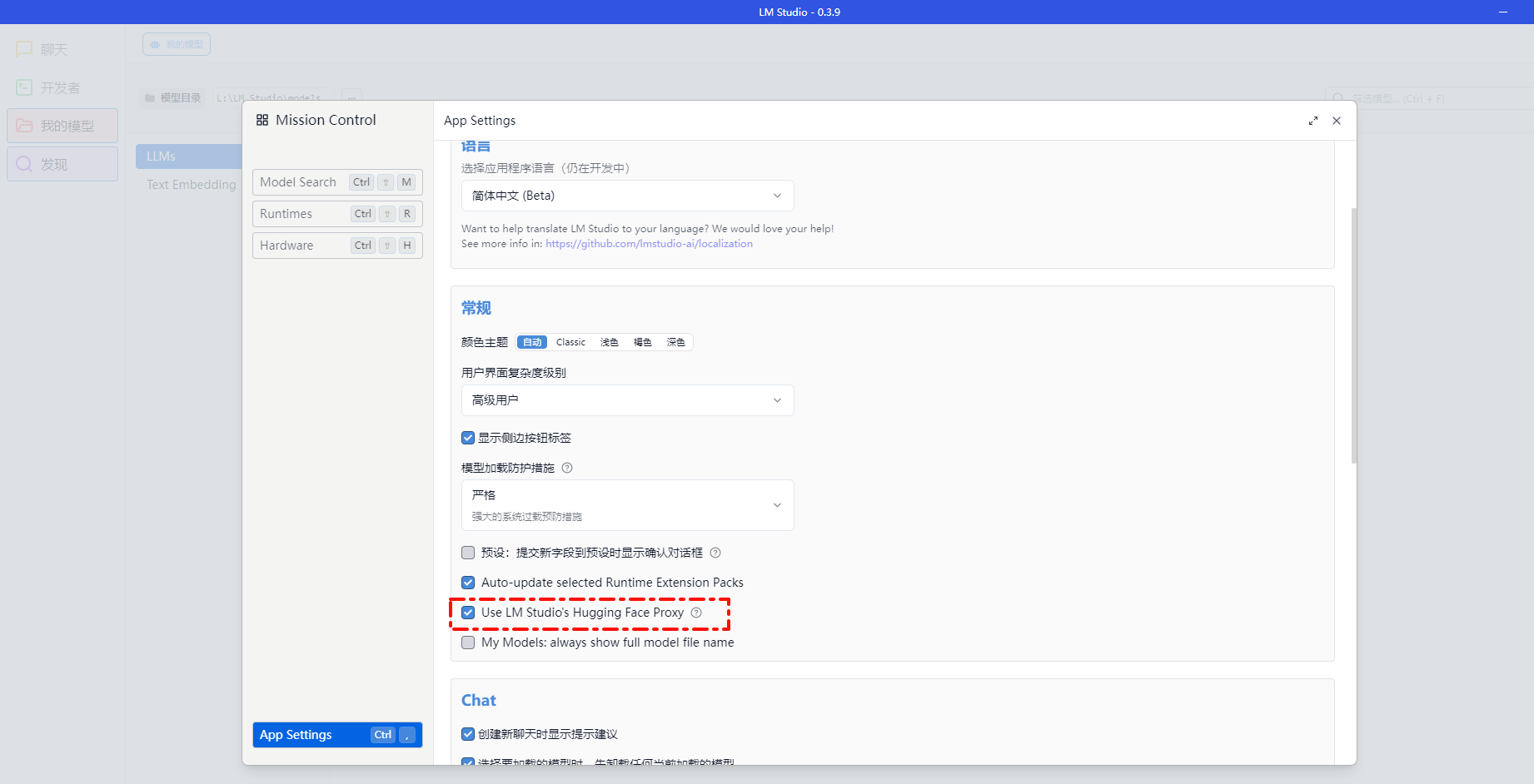

打开Hugging Face代理配置项

不需魔法,只需要打开这项配置Use LM Studio's Hugging Face Proxy,LM Studio配置的Hugging Face的网络代理,便可以联通Hugging Face下载模型了

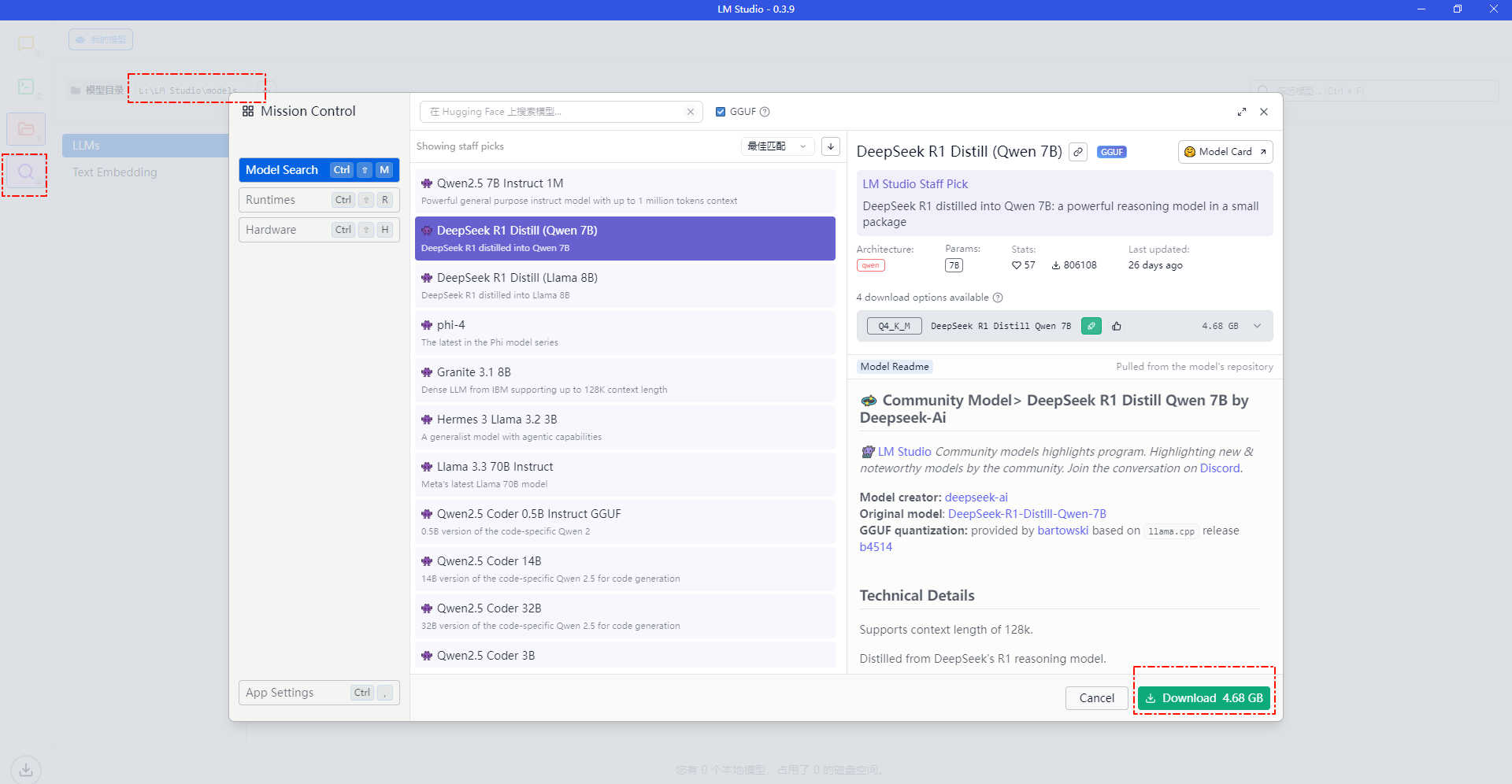

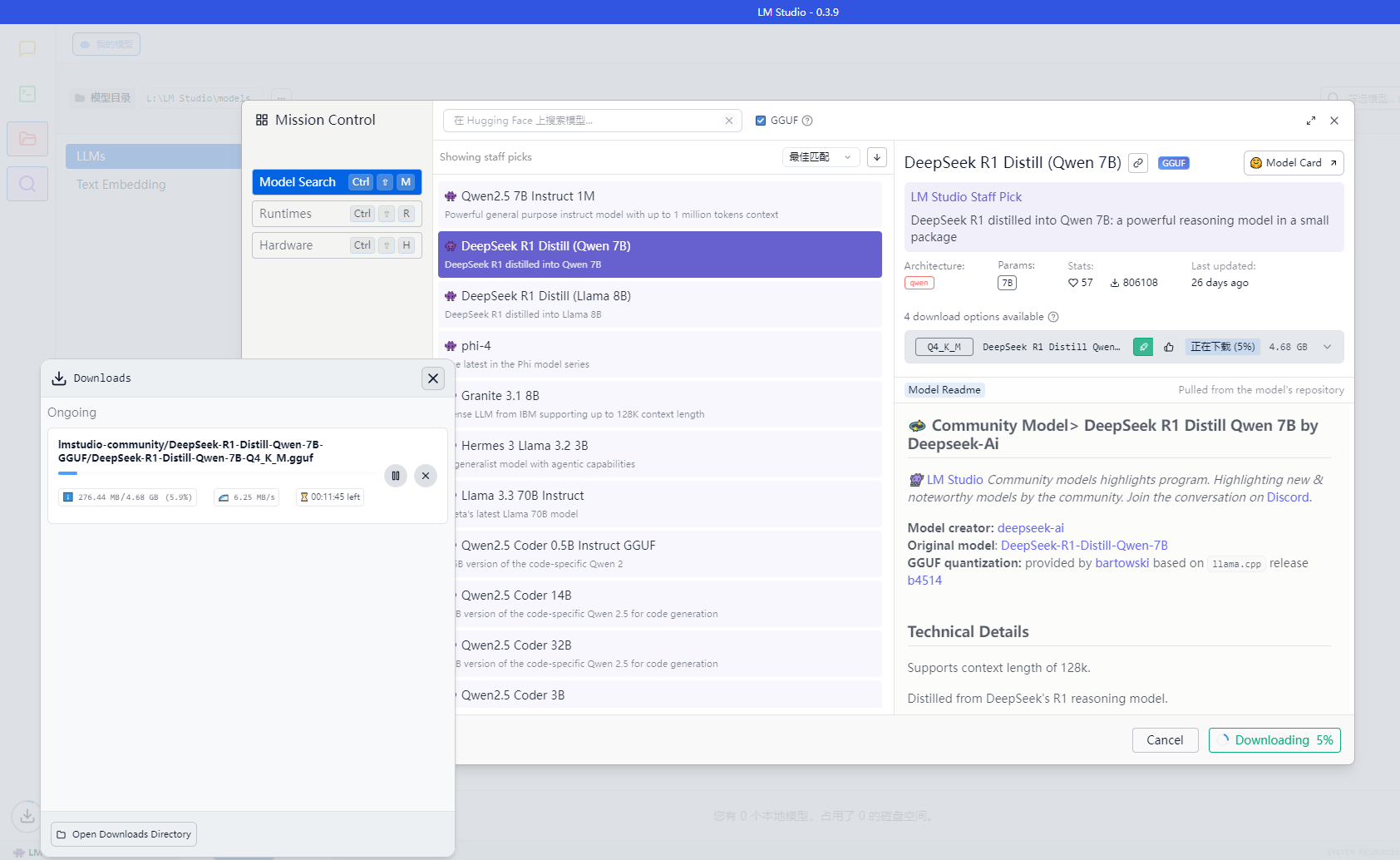

下载模型-软件内-不需魔法

打开上述配置,可在模型搜索界面直接获取到模型信息,比如下载一个DeepSeek R1 Distill Qwen 7B的模型

Distill 表示蒸馏模型

例如DeepSeek R1 Distill Qwen 7B 就是DeepSeek R1 模型对 Qwen-7B 进行蒸馏得到的模型,

- 技术特点

- 蒸馏技术运用:蒸馏是一种模型压缩和优化技术,通过将大模型(教师模型)的知识传递给小模型(学生模型),使小模型在保持一定性能的同时,减少计算量和存储需求,提高运行效率。DeepSeek R1 Distill Qwen 7B 就是利用 DeepSeek R1 的知识对 Qwen-7B 进行蒸馏,让 Qwen-7B 能学习到 DeepSeek R1 的一些优秀特性,如更好的推理能力等。

- 与原模型关系:它保留了 Qwen-7B 的一些基础架构和特性,同时融入了 DeepSeek R1 的部分优势,是在两者基础上进行融合创新的结果。

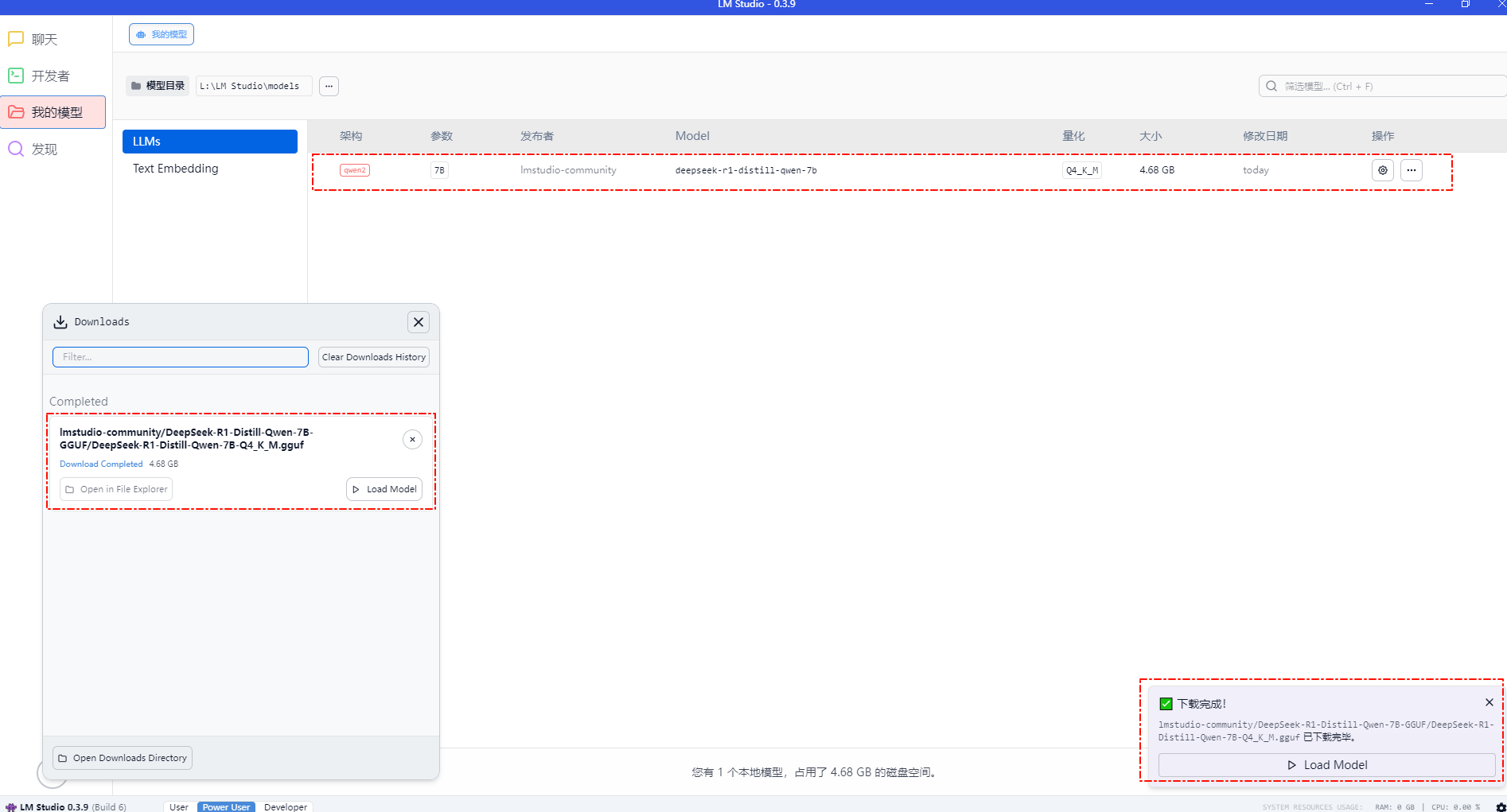

下载完毕,正常读取

检查存放路径,没有问题

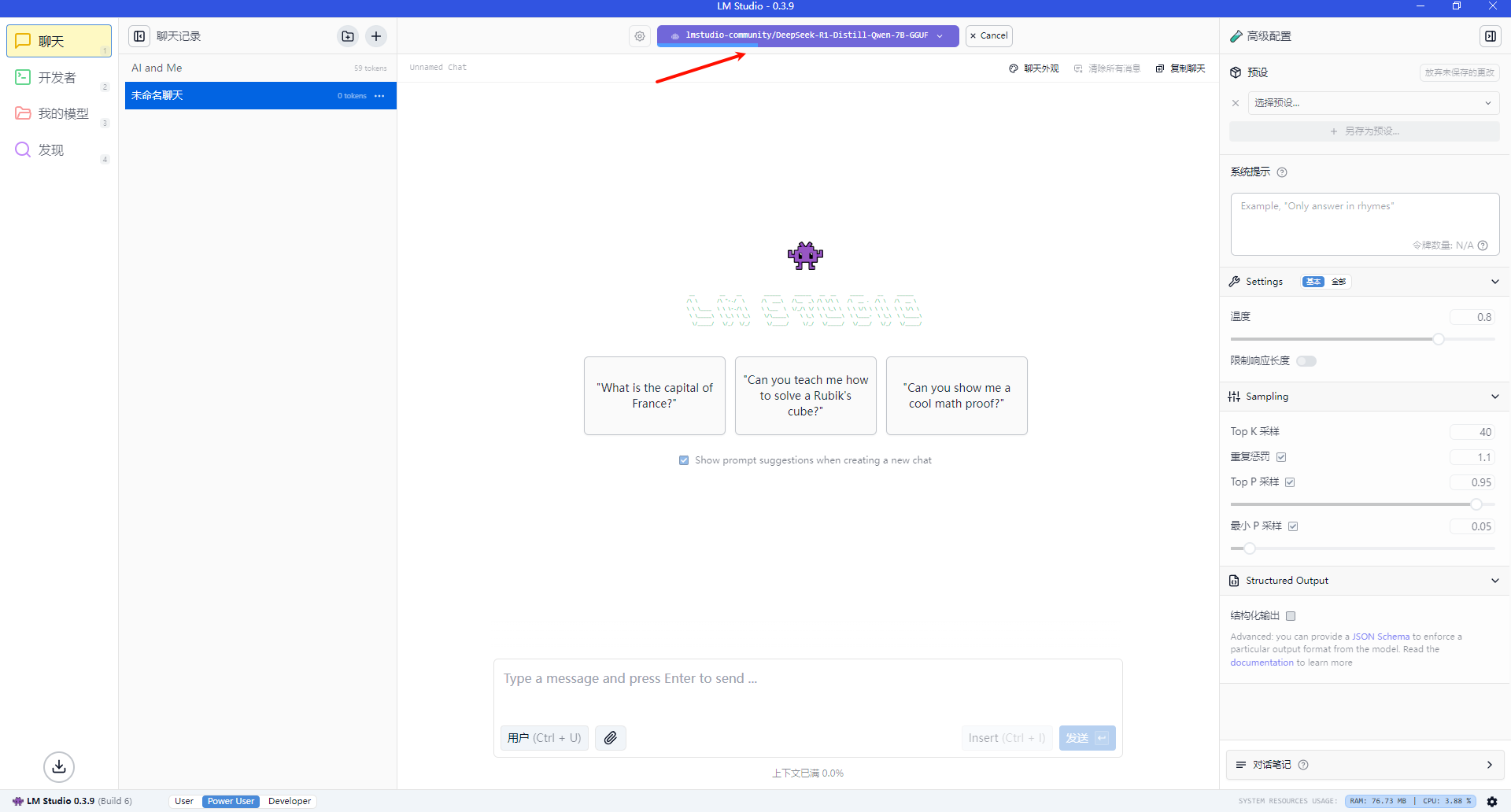

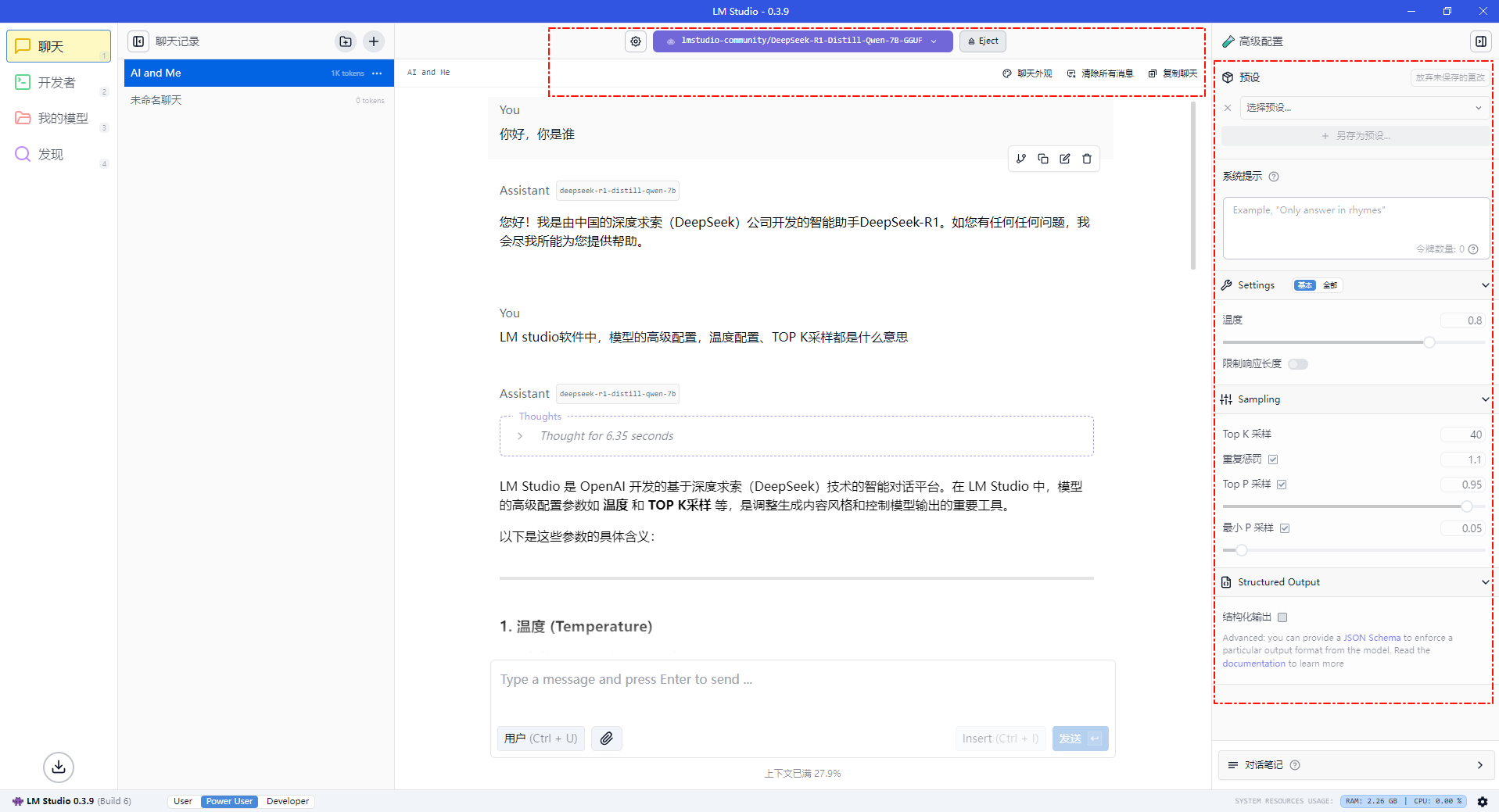

软件内直接使用

选择模型加载,等待加载完毕后可进行对话,可以从内存随时卸载,另外模型参数可以调整

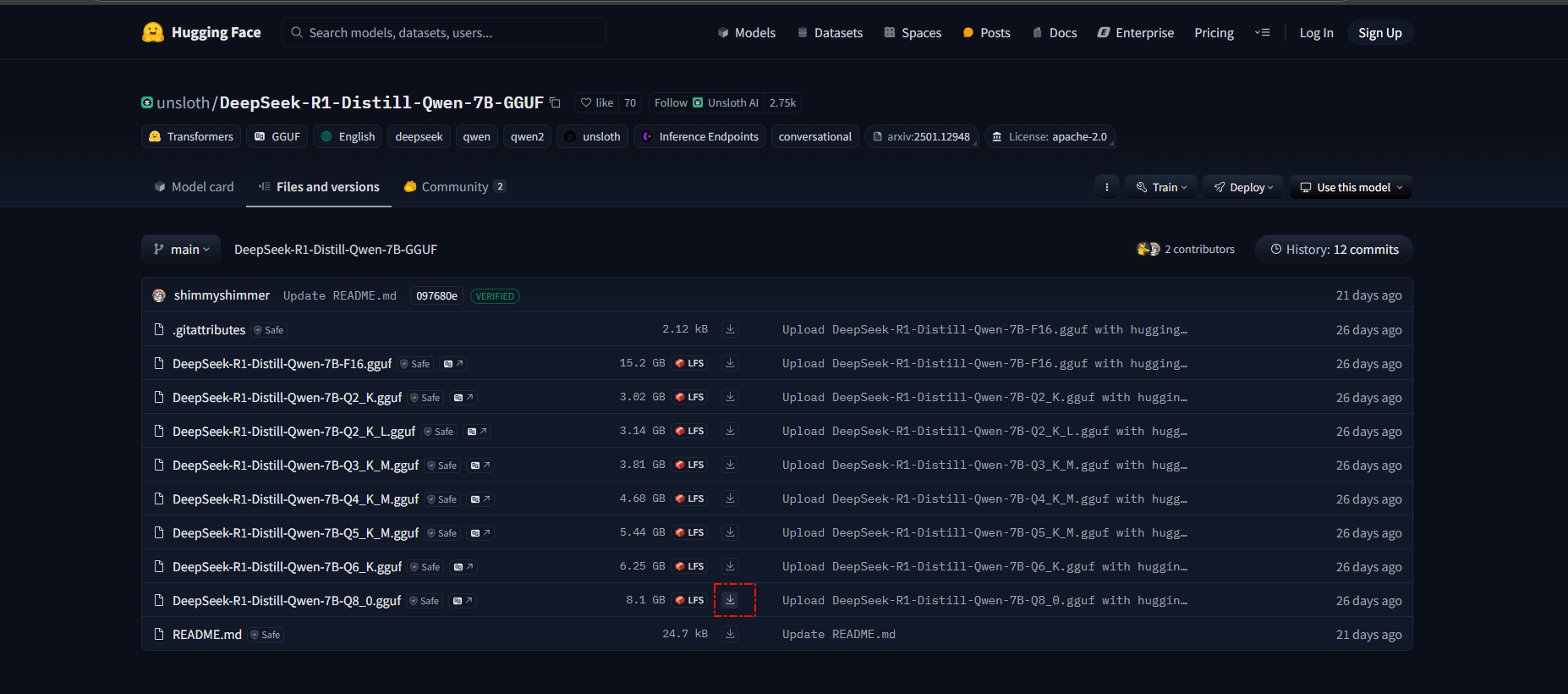

下载模型-其他来源-需魔法

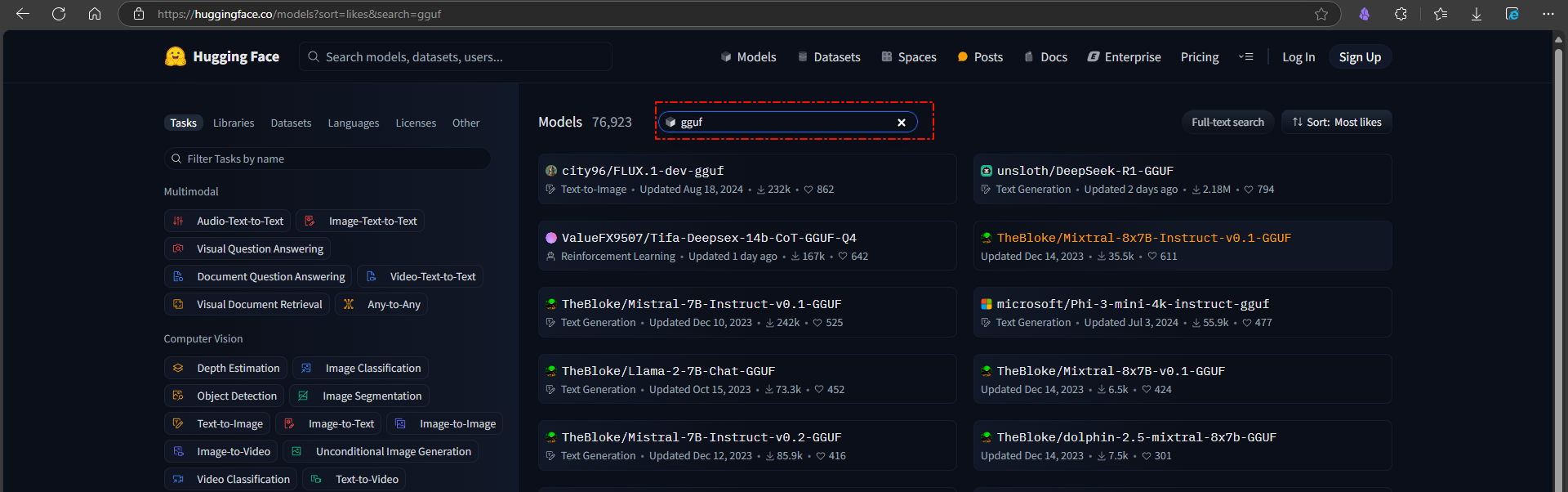

比如从Hugging Face网站下载,需魔法,而且注意要下载GGUF格式的模型,LM Studio才支持。

左侧栏有模型的类型,搜索、排序找到想要的模型,过滤参数直接加上GGUF

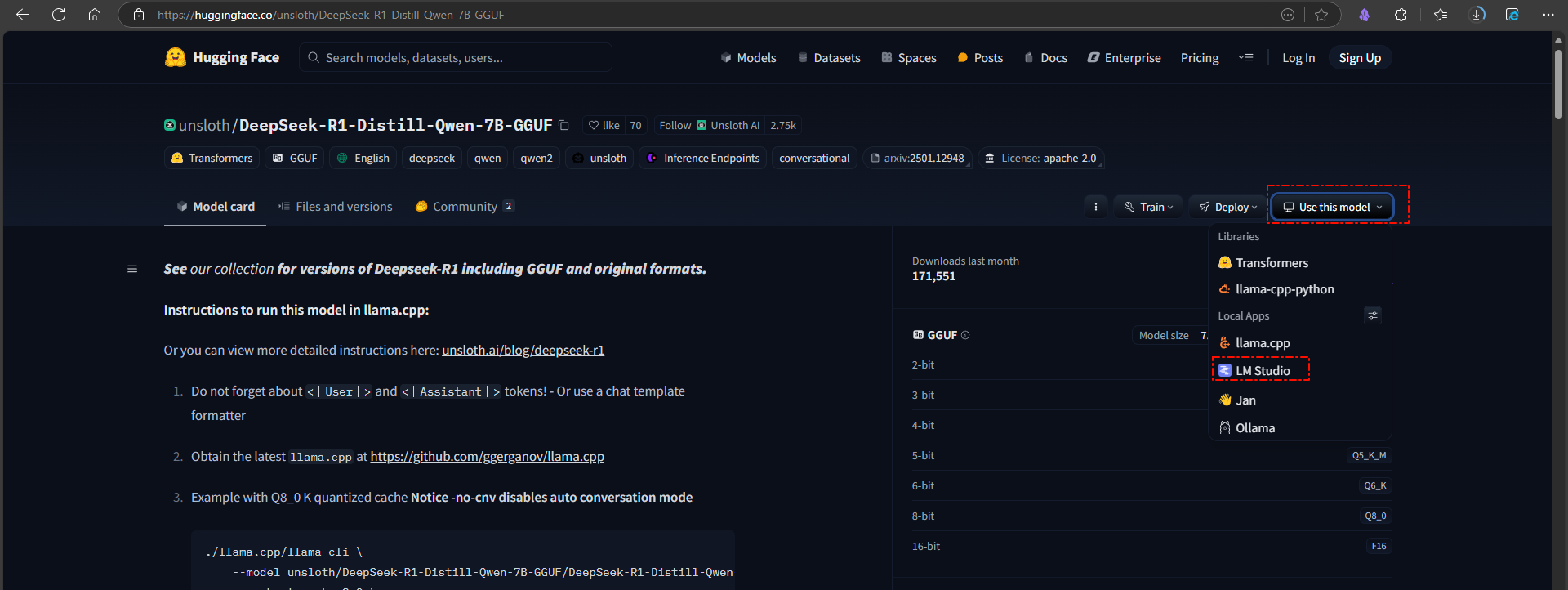

GGUF的可以直接点USE this model里选LM Studio(弹框确认直接进入LM Studio软件下载),或者直接在文件处点击下载(浏览器下载)

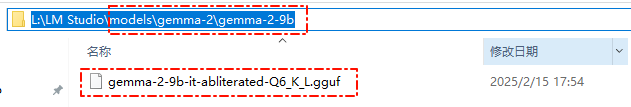

注意这里下载成功后,需要手动把模型gguf文件放到之前配置的模型目录下的再深入两层的文件夹(自己新建立),才能被识别到,如下图所示:

实际这两层目录对应在软件上的显示就是,第一层文件夹名对应是发布者这里显示的,第二层文件夹名是对应Model这显示的

RAG知识库测试

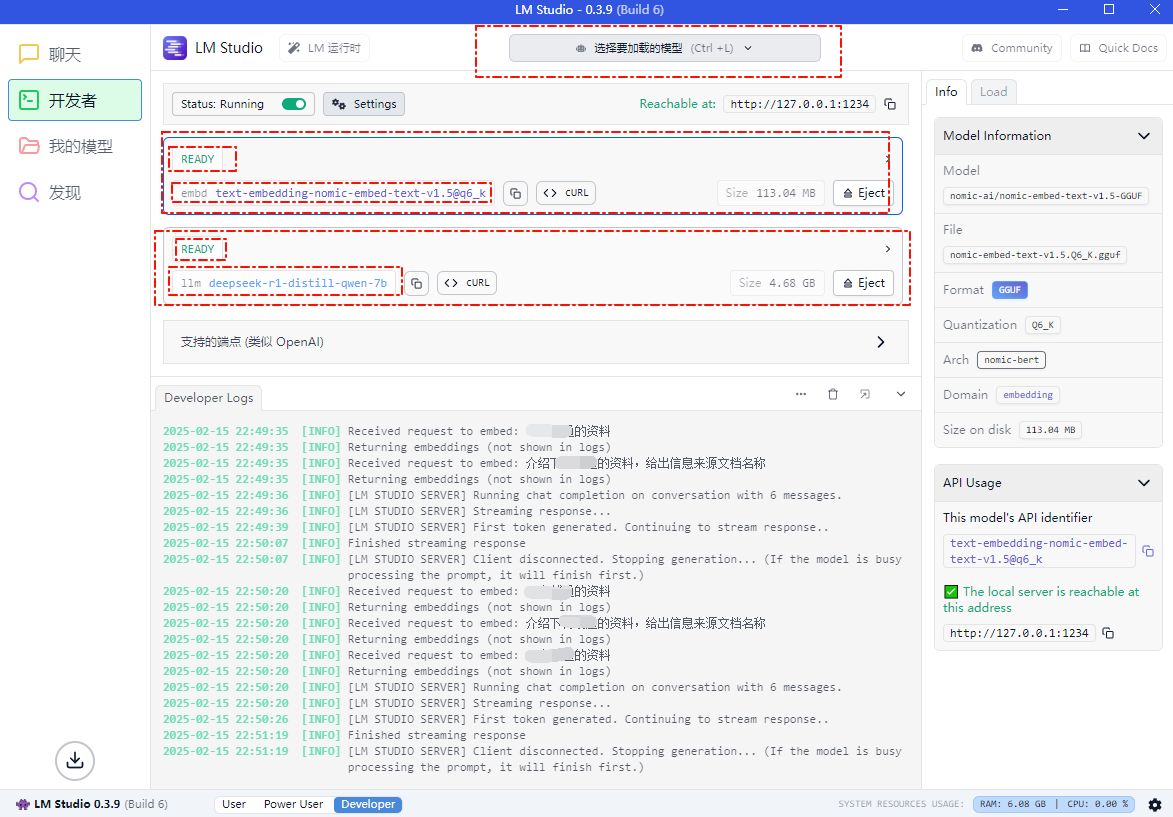

LM Studio加载好模型

和Ollama一样,需要LLM模型和embd向量模型

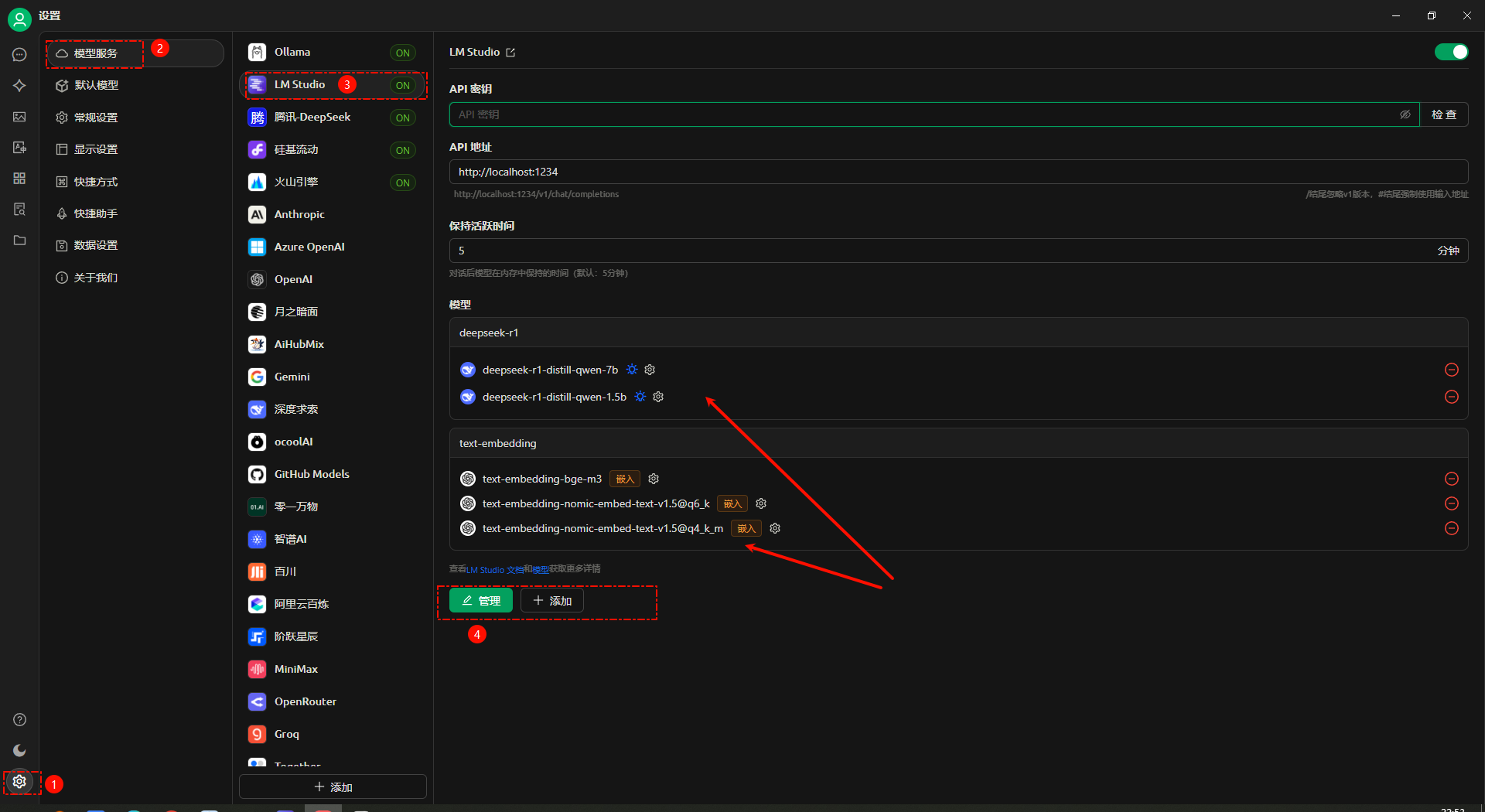

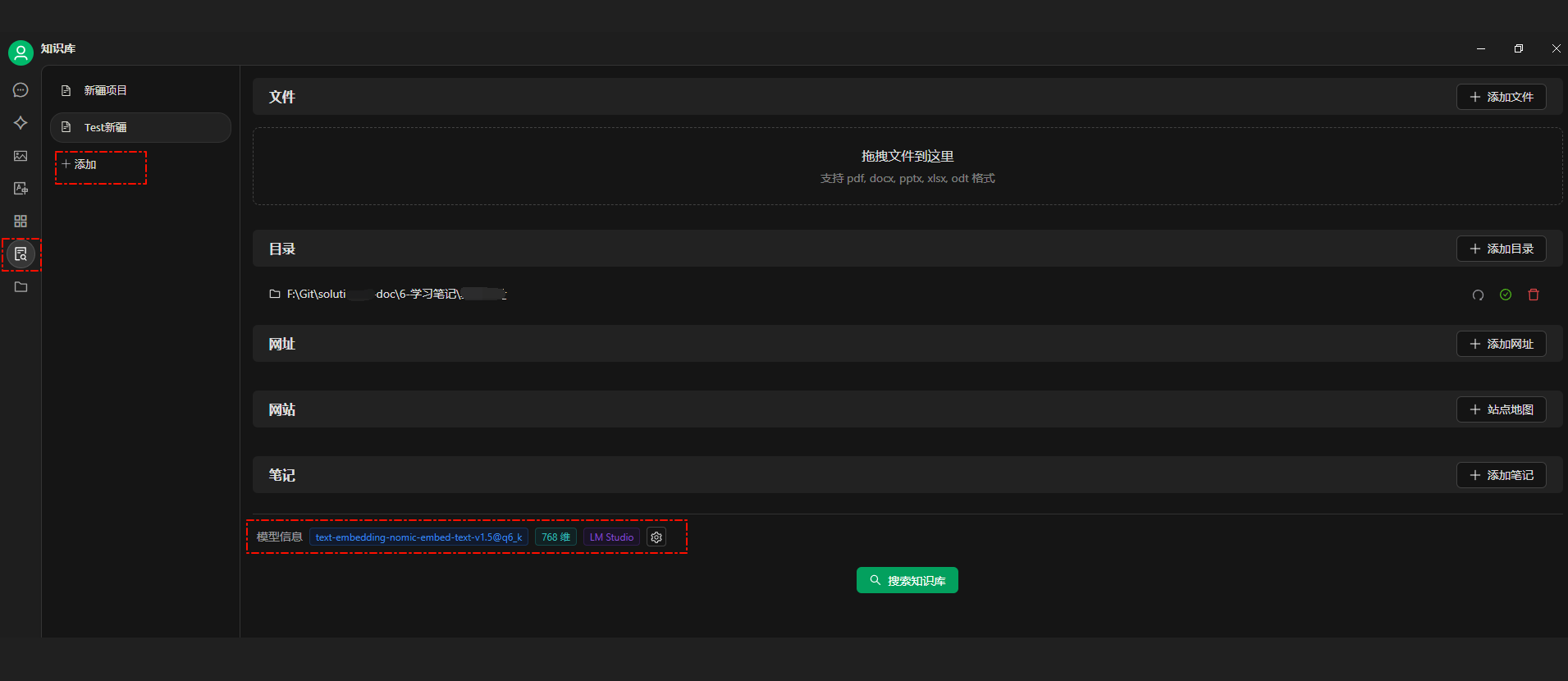

CherryStudio

逻辑与使用ollama做本地服务一样,LM Studio作为运行大模型的载体,提供本地模型API服务,CherryStudio、AnythingLLM等客户端工具

- 配置模型

- 配置知识库

新建知识库,导入文件或者文件夹,选择向量模型进行向量化处理,比如选上述LM Studio的向量模型处理,LM开发者界面会显示服务端打印

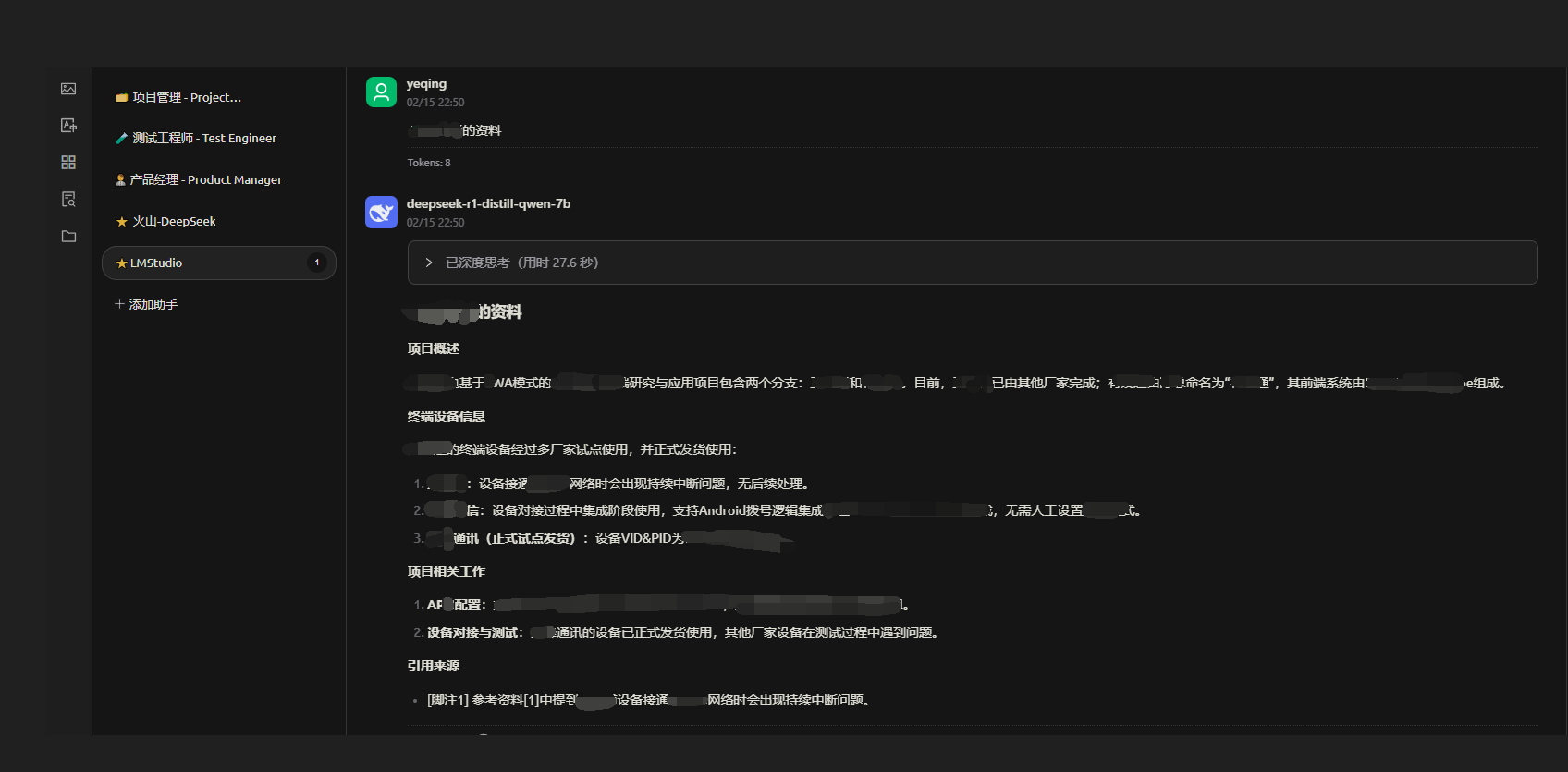

- 对话测试

CherryStudio知识库的缺点是没有列出来具体的引用参考资料文件名(或者带上开关显示引用文件功能更合理)。优点是能直接配置目录,操作简单。

总结

LM Studio和Ollama都是本地部署大模型的工具;LM Studio图形化界面,功能更多,操作更简单友好,界面提示准确,遇到问题更容易处理。

- 安装配置更友好

- 如果不装其他客户端直接使用它下载模型本地部署,只使用Chat功能,LM Studio更适合

- 如果只是用常见模型提供服务,Ollama更适合;如果要使用Hugging Face上更多的模型、量化GGUF模型,LM Studio更适合

- 追求图形界面操作和简易舒适度,LM Studio更适合

- Ollama完全开源,LM Studio核心部分闭源;本地私有化数据,可以通过设置防火墙出入规则来放置LM Studio外漏数据(具体网上可搜到教程)

使用LM Studio几个要点

上文中都有提到,容易踩坑的点

- 模型文件夹配置

- 打开Hugging Face 代理设置(下载最新版LM Studio软件)

- 非工具内直接安装,网络单独下载的GGUF模型,需要配置双层文件夹才能被识别到